Заявка на услуги DST

Наш специалист свяжется с вами, обсудит оптимальную стратегию сотрудничества,

поможет сформировать бизнес требования и рассчитает стоимость услуг.

Полное руководство по защите данных, моделей и пользователей в эпоху GenAI. В этой статье от разработчиков компании DST Global, приведены практические контрольные списки, которые помогут предприятиям безопасно внедрить GenAI.

Генеративный ИИ (GenAI) преобразует работу организаций, обеспечивая автоматизацию, создание контента и интеллектуальное принятие решений в беспрецедентных масштабах. От чат-ботов на базе ИИ до продвинутой генерации кода и креативного дизайна, GenAI производит революцию в отраслях, повышая эффективность и инновации. Однако вместе с этими достижениями возникают и значительные риски безопасности, которые организациям необходимо учитывать.

Проблема в том, что по мере того, как системы ИИ становятся все более интеллектуальными и сложными, они также сталкиваются с меняющимися угрозами и рисками. Обеспечение безопасности ИИ на всех этапах разработки и развертывания имеет решающее значение.

В этой статье приводятся практические контрольные списки, которые помогут предприятиям безопасно внедрять GenAI. Понимая ключевые риски безопасности, внедряя основные технологии и следуя передовым практикам, организации могут использовать мощь GenAI, обеспечивая при этом защиту своих данных, моделей и пользователей.

Контрольные списки разделены на две категории:

- Основные риски безопасности GenAI

- Основные технологии безопасности для GenAI

Основные риски безопасности генеративного ИИ

GenAI вводит новые риски безопасности, которые организации должны учитывать. Угрозы включают утечки данных, манипуляции с моделями и несанкционированный доступ. Эти риски могут привести к серьезным нарушениям конфиденциальности и безопасности без надлежащих мер безопасности.

1. Риски, связанные с конфиденциальностью данных и соответствием требованиям

Генеративный ИИ может раскрыть конфиденциальные данные, что приведет к юридическим нарушениям в соответствии с такими правилами, как GDPR и HIPAA. Организации сталкиваются с правовыми, финансовыми и репутационными рисками, если модели ИИ обрабатывают конфиденциальную информацию без мер безопасности. Обеспечение соответствия требует строгой обработки данных, контроля доступа и регулярных аудитов.

Например, в 2023 году сотрудники Samsung случайно слили конфиденциальные данные компании, введя их в ChatGPT, что вызвало серьезные опасения по поводу конфиденциальности корпоративных данных и неправомерного использования ИИ. Узнайте больше о случайной утечке данных здесь .

Вот шаги по устранению рисков, связанных с конфиденциальностью данных и соответствием требованиям:

- Ограничьте доступ ИИ к конфиденциальным данным с помощью ролевого управления

- Внедрить анонимизацию и шифрование данных перед обработкой ИИ

- Аудит взаимодействия ИИ на предмет соответствия GDPR , HIPAA и т. д.

- Используйте инструменты управления ИИ для обеспечения соблюдения политик защиты данных

2. Дезинформация и предвзятость

Модели ИИ могут генерировать ложную или вводящую в заблуждение информацию, обычно называемую галлюцинациями. ИИ может усиливать стереотипы и давать несправедливые результаты, если обучается на предвзятых данных. Организации должны гарантировать, что контент, сгенерированный ИИ, является точным, этичным и свободным от предвзятости. Инцидент такого рода произошел в 2023 году, когда новостной сайт, работающий на основе ИИ, опубликовал вводящие в заблуждение и фейковые статьи , что привело к дезинформации общественности и подорвало его авторитет. Чтобы избежать дезинформации и предвзятости:

- Регулярно проверяйте модели ИИ на предмет предвзятости и точности

- Используйте разнообразные, высококачественные данные для обучения

- Внедрить человеческий анализ критических результатов ИИ

- Установить этические принципы ИИ для обеспечения ответственного использования

3. Несанкционированный доступ и неправомерное использование

Неавторизованные пользователи могут получить доступ к моделям ИИ без надлежащих мер безопасности, что приводит к краже данных или манипулированию ими. Как инсайдеры, так и внешние хакеры представляют риск, особенно если безопасность API слаба или неправильно настроена. В одном случае неправильно настроенный чат-бот ИИ публично раскрыл разговоры пользователей из-за уязвимостей API, что поставило под угрозу конфиденциальность. Вот контрольный список, чтобы предотвратить возникновение проблем с несанкционированным доступом и неправомерным использованием:

- Внедрение многофакторной аутентификации (MFA) для доступа к ИИ

- Внедрение контроля доступа на основе ролей

- Отслеживайте журналы активности ИИ на предмет подозрительного поведения

- Проводите регулярные аудиты безопасности и тесты на проникновение

4. Отравление данных

Злоумышленники могут манипулировать данными обучения ИИ, внедряя вредоносные входные данные и искажая выходные данные модели. Это может привести к предвзятым решениям, дезинформации или уязвимостям, которые можно эксплуатировать. В одном эксперименте исследователи продемонстрировали, как отравление наборов данных ИИ может манипулировать системами распознавания лиц, заставляя их неправильно идентифицировать людей. Вот контрольный список для предотвращения отравления данных:

- Проверка и очистка данных обучения перед обработкой ИИ

- Используйте дифференциальную конфиденциальность для предотвращения манипулирования данными

- Развертывание инструментов обнаружения аномалий для выявления зараженных данных

- Переобучение моделей с использованием проверенных и разнообразных наборов данных

5. Поддельный «ChatGPT» и атаки с целью выдачи себя за другое лицо

Мошенники создают поддельные инструменты ИИ, имитирующие ChatGPT или другие службы ИИ, чтобы обманом заставить пользователей поделиться конфиденциальными данными или установить вредоносное ПО.

Вот контрольный список для предотвращения поддельных атак «ChatGPT» и атак с использованием псевдонима:

- Используйте только официальные инструменты ИИ из проверенных источников

- Просвещайте сотрудников в вопросах мошенничества с использованием фальшивого ИИ и фишинга

- Развертывание средств безопасности для обнаружения мошеннических служб ИИ

- Сообщайте властям о поддельных платформах ИИ

6. Кража моделей

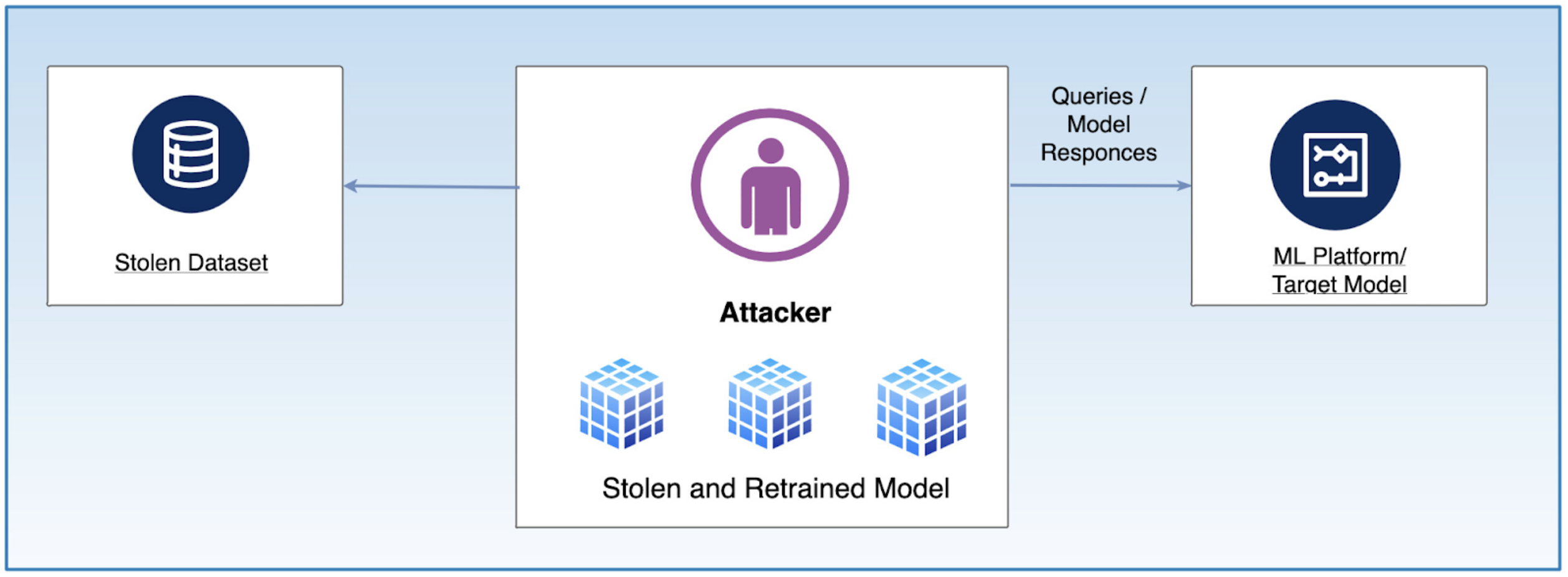

Злоумышленники могут извлекать запатентованные модели ИИ, эксплуатируя API и анализируя ответы, что приводит к краже интеллектуальной собственности и конкурентному невыгодному положению. Как обнаружено в исследовании Университета штата Северная Каролина , «Исследователи продемонстрировали возможность украсть модель искусственного интеллекта (ИИ) без взлома устройства, на котором эта модель работала. Этот метод является новым в том смысле, что он работает даже тогда, когда у вора нет никаких предварительных знаний о программном обеспечении или архитектуре, поддерживающих ИИ».

Диаграмма иллюстрирует процесс кражи модели, где злоумышленник отправляет несколько запросов целевой модели машинного обучения и собирает соответствующие ответы. Используя эти входы и выходы, злоумышленник затем обучает украденную модель, которая имитирует поведение оригинала, что потенциально приводит к краже интеллектуальной собственности и несанкционированному использованию.

Чтобы предотвратить кражу моделей:

- Ограничьте доступ к API и установите ограничения на частоту запросов

- Шифровать модели ИИ во время развертывания

- Используйте водяные знаки для отслеживания несанкционированного использования

- Мониторинг активности API на предмет подозрительных шаблонов извлечения

7. Атаки с инверсией модели

Хакеры могут проводить обратную разработку моделей ИИ для восстановления конфиденциальных данных обучения, потенциально раскрывая конфиденциальную или личную информацию. В одном случае исследователи реконструировали лица из модели распознавания лиц ИИ, раскрывая личные данные пользователей, используемые в обучении. Андре Чжоу собрал список ресурсов и исследований, связанных с атаками инверсии моделей, в своем репозитории GitHub .

Атака инверсии модели похожа на атаку кражи модели. Атака инверсии модели извлекает конфиденциальные данные обучения, анализируя выходные данные модели, выводит частные входные данные, создавая риск конфиденциальности, и предоставляет злоумышленникам доступ к конфиденциальным или персональным данным. Между тем, атака кражи модели воспроизводит функциональность целевой модели с помощью запросов и ответов, позволяет кражу интеллектуальной собственности путем воссоздания модели и позволяет злоумышленникам получить функциональную копию поведения модели.

Вот шаги, которые вы можете предпринять для предотвращения атак с инверсией модели:

- Используйте дифференциальную конфиденциальность для защиты обучающих данных

- Ограничьте раскрытие модели, ограничив ответы API

- Применяйте состязательную защиту для предотвращения инверсионных атак

- Регулярно оценивайте модели ИИ на предмет уязвимостей

8. Социальная инженерия с использованием искусственного интеллекта

ИИ может генерировать высокореалистичные фишинговые письма, видео с глубокими подделками и имитацию голоса, что делает атаки социальной инженерии более эффективными. Например, киберпреступники использовали голоса, сгенерированные ИИ, чтобы выдавать себя за руководителей компании в европейской компании, успешно авторизовав мошеннические финансовые транзакции на сумму 220 000 евро.

Ниже приведены меры, которые можно предпринять для предотвращения социальной инженерии с использованием искусственного интеллекта:

- Обучайте сотрудников распознавать мошенничество, сгенерированное искусственным интеллектом, используя инструменты с открытым исходным кодом, такие как SynthId от Google (или коммерческие инструменты)

- Развертывание инструментов безопасности на базе искусственного интеллекта для обнаружения дипфейков

- Используйте многофакторную аутентификацию для финансовых транзакций

- Отслеживайте необычные шаблоны коммуникаций

Основные технологии безопасности для GenAI

Обеспечение безопасности генеративного ИИ подразумевает использование шифрования, контроля доступа и безопасных API. Инструменты мониторинга улавливают необычную активность, а средства защиты защищают от атак. Соблюдение правил конфиденциальности помогает обеспечить безопасное и справедливое использование ИИ. Нам также необходимо рассмотреть следующие темы для повышения уровня безопасности при использовании ИИ.

1. Предотвращение потери данных

Решения по предотвращению потери данных (DLP) отслеживают и контролируют поток данных, чтобы предотвратить утечку или нецелевое использование конфиденциальной информации. Вот несколько способов внедрения решений DLP:

- Используйте инструменты DLP на основе искусственного интеллекта для обнаружения и блокировки несанкционированного обмена данными

- Применяйте строгие политики классификации и доступа к данным

- Контролируйте результаты, генерируемые ИИ, чтобы предотвратить непреднамеренные утечки данных

- Регулярно проверяйте журналы на предмет подозрительной активности

2. Архитектура с нулевым доверием

Архитектура нулевого доверия (ZTA) обеспечивает строгий контроль доступа, проверяя каждый запрос на основе принципов идентификации, контекста и наименьших привилегий. Вот контрольный список для внедрения архитектуры нулевого доверия:

- Внедрить MFA для доступа ИИ

- Используйте инструменты управления идентификацией и доступом для обеспечения минимальных привилегий

- Постоянно отслеживать и проверять взаимодействие пользователя и ИИ

- Сегментация сетей для ограничения воздействия систем ИИ

3. Шифрование и конфиденциальные вычисления

Шифрование защищает данные ИИ в состоянии покоя и при передаче, а конфиденциальные вычисления защищают конфиденциальные операции ИИ в безопасных средах. Вот контрольный список для внедрения шифрования и конфиденциальных вычислений:

- Шифрование данных с использованием AES-256 для хранения и TLS 1.2+ для передачи

- Используйте аппаратные защищенные анклавы для обработки ИИ

- Реализовать гомоморфное шифрование для вычислений ИИ, сохраняющих конфиденциальность

- Регулярно обновляйте криптографические протоколы для предотвращения уязвимостей

Заключение

Обеспечение безопасности генеративного ИИ означает принятие надлежащих мер для защиты данных, моделей и пользователей; поэтому организации должны постоянно совершенствовать свои стратегии безопасности и активно устранять ключевые риски безопасности. Это можно сделать отчасти путем внедрения строгого контроля доступа, политик защиты данных и регулярных тестов безопасности, а также проведения надлежащих исследований, чтобы убедиться, что организации удовлетворяют свои собственные потребности и нормативные требования. Следуя контрольным спискам, представленным в этой статье, организации могут безопасно и инновационно использовать генеративный ИИ.

Наш специалист свяжется с вами, обсудит оптимальную стратегию сотрудничества,

поможет сформировать бизнес требования и рассчитает стоимость услуг.

Ижевск, ул. Воткинское шоссе 170 Е.

Региональный оператор Сколково. Технопарк Нобель

Задать вопрос по почте

Что такое GenAI и как он работает в сфере кибербезопасности?

Генеративный ИИ создает новые реалистичные данные, используя передовые модели глубокого обучения, такие как преобразователи и генеративно-состязательные сети — GAN. Хотя эти технологии часто связаны с творческими задачами, такими как написание эссе или дизайн произведений искусства, их важность в кибербезопасности становится все более очевидной. GenAI играет важную роль в кибербезопасности, выявляя угрозы, автоматизируя реагирование и улучшая протоколы безопасности посредством анализа и репликации сложных шаблонов данных. Однако эта мощная технология также несет в себе риски. Те же возможности, которые делают GenAI эффективным инструментом защиты, могут быть использованы злоумышленниками для проведения изощренных атак.

Применение GenAI в кибербезопасности

1. Обнаружение и прогнозирование угроз

Одним из величайших преимуществ GenAI в сфере кибербезопасности является его способность обнаруживать и прогнозировать атаки. Традиционные методы обнаружения угроз часто не справляются с новыми и развивающимися угрозами, поскольку они в значительной степени полагаются на установленные критерии и исторические данные. Напротив, GenAI может генерировать наборы данных, моделирующие потенциальные сценарии атак, что позволяет организациям выявлять уязвимости до того, как они будут использованы.

Кроме того, модели GenAI могут анализировать большие объемы данных сетевого трафика для обнаружения аномалий, которые могут указывать на кибератаку. Например, система искусственного интеллекта может отмечать необычные схемы входа в систему или неожиданную передачу данных для дальнейшего расследования, обеспечивая систему раннего предупреждения о потенциальных угрозах.

2. Реагирование на инциденты и автоматизация

В случае кибератаки решающее значение имеют быстрые действия. Решения на базе GenAI позволяют анализировать инциденты в режиме реального времени, выявлять угрозы и принимать контрмеры. Например, GenAI может изолировать скомпрометированные системы, остановить распространение программ-вымогателей и уведомить команду безопасности при обнаружении атаки.

За счет значительного сокращения времени реагирования эти возможности минимизируют потенциальный ущерб от кибератак. Кроме того, GenAI автоматизирует рутинные задачи кибербезопасности, такие как управление исправлениями, позволяя экспертам сосредоточиться на сложных, высокоприоритетных проблемах.

3. Обнаружение и предотвращение мошенничества

Обнаружение мошенничества является постоянной проблемой в таких отраслях, как финансы и электронная коммерция. GenAI особенно эффективен в распознавании тонких закономерностей, которые могут указывать на мошенническую деятельность. Создавая реалистичные, но синтетические данные, эти модели могут повысить способность систем искусственного интеллекта выявлять мошенничество, попытки фишинга или фальшивые транзакции.

Например, GenAI может повысить безопасность электронной почты, моделируя фишинговые письма и оценивая, насколько хорошо организация может противостоять таким угрозам. Такой упреждающий подход позволяет компаниям усилить свою защиту от мошенничества.

4. Анализ киберугроз

Разведка киберугроз включает сбор и анализ информации о потенциальных рисках для организации. GenAI поддерживает эти усилия, синтезируя огромные объемы неструктурированных данных из таких источников, как новостные статьи, социальные сети и форумы в даркнете.

Способность GenAI анализировать и генерировать текст, похожий на человеческий, позволяет ему распознавать закономерности, выявлять возникающие угрозы и предоставлять полезную информацию. Эта информация в режиме реального времени помогает организациям оставаться на шаг впереди противников и улучшает общее состояние кибербезопасности.

Проблемы и риски GenAI в кибербезопасности

Хотя GenAI подает большие надежды, он, конечно, имеет свои проблемы.

Использование оружия злоумышленниками

Киберпреступники могут использовать те же инструменты, на которые полагаются эксперты по кибербезопасности. Например, GenAI может генерировать вредоносный код или создавать убедительные фишинговые электронные письма. Такая двойная природа GenAI требует постоянной бдительности и превентивных мер со стороны специалистов по кибербезопасности.

Проблемы конфиденциальности данных

Обучение моделей GenAI часто требует огромных объемов данных, что может привести к проблемам конфиденциальности. Организации должны гарантировать, что конфиденциальные данные, используемые для обучения ИИ, анонимны и соответствуют таким правилам, как GDPR, для защиты конфиденциальности личности.

Чрезмерная зависимость от автоматизации

Хотя автоматизация повышает эффективность, чрезмерная зависимость от инструментов GenAI может привести к самоуспокоенности команд кибербезопасности. Человеческий надзор необходим для обеспечения эффективного и этичного функционирования систем ИИ, а также для решения сложных сценариев, с которыми ИИ может не справиться должным образом.

Для начала скажем, что появление компьютеров заставило людей пересмотреть сам подход к ошибкам. Логика компьютерных систем требует считать, что компьютер всегда вычисляет точно (в соответствии с алгоритмом). Ошибка в работе компьютера — это либо аппаратный отказ в выполнении определенной функции, либо сбой алгоритмов, а не самих вычислительных машин.

Но появление более сложных прикладных систем породило понимание того, что не все вычисления можно считать успешными. С переходом к облачным и сервисным вычислениям разница между алгоритмами и аппаратным оснащением стёрлась. Появились «общие» ошибки, связанные с алгоритмами вычислений, но переносимые на всю компьютерную систему в целом.

С появлением GenAI эта особенность проявляется уже в полную силу. Причины его ошибок уже не делятся по источнику их появления: компьютер, алгоритм, структура системы. Поэтому эти «единые» ошибки требуют осмысления. Чем ошибки GenAI отличаются от тех, которые делает человек или компьютер?

Приведем еще один пример использования ИИ — в системе заказов в сети ресторанов McDonald’s. Начиная с 2020 года, там стали применять ИИ-систему для размещения заказов. Разработка была выполнена в партнерстве с IBM.

Ошибки в ее работе не замедлили себя ждать. Блогеры стали сообщать, то о получении заказа из девяти чашек чая вместо одной, то о получении заказа с добавлением бекона к мороженому. После серии таких скандальных видеороликов в прошлом году было решено отказаться от использования этой ИИ-системы и возврату к размещению заказов через человека.

Хайп пройдет и все откажутся от ИИ? Вряд ли. Конкуренты «Макдональдса», такие как White Castle и Wendy’s, сразу же поспешили сообщить о своих успехах по части автоматизации работы с заказами. Поэтому никто не собирается отказываться от ИИ, но тема своевременного выявления ошибок в работе ИИ-систем остается актуальной.

Генеративный ИИ и его ошибки в сфере кибербезопасности

Существует заметный контраст между потребностью в автоматизации, которую мог бы удовлетворить GenAI, и готовностью компаний внедрять машинное обучение и генеративный ИИ для обеспечения кибербезопасности. Если говорить в общем, то прежде всего высказываются опасения относительно конфиденциальности данных, сохранения репутации, соблюдения требований законодательства или охраны интеллектуальной собственности. Существенную роль играет влияние GenAI на качество и производительность работы.

Некоторые вендоры внедряют ИИ-помощников в SIEM-системы и другие защитные инструменты, однако большинству трудно представить себе, например, реагирование с помощью ИИ – во всяком случае, на нынешнем этапе развития. В контексте обеспечения ИБ возможные ошибки GenAI особенно значимы и могут представлять критическую опасность. Даже в тех случаях, когда реагирование на инциденты выполняется силами экспертов-людей, есть немало историй, когда заказчик остаётся недоволен оказываемым воздействием на инфраструктуру. Бесконтрольная же деятельность ИИ-агента на критически важных активах может оказаться попросту разрушительной.

Не следует забывать и о том, что GenAI-модели подвержены рискам раскрытия данных. Применение чат-ботов общего пользования для обработки конфиденциальной информации может приводить к ошибочному разглашению сведений, имеющих важное значение для компании. Поэтому, как отмечали эксперты в эфире AM Live, применение ИИ для обеспечения кибербезопасности ограничено: во избежание утечек нужно пользоваться своими, внутренними моделями.

Отметим, что разработчики GenAI знают об этих проблемах и ищут решения, стремясь добиться доверия пользователей к GenAI и сделать его применение безопасным.

Выводы

ИИ уже нашел применение для различных прикладных задач. Его успех связан с быстрым получением требуемого результата. Но при этом важно, что когда контент создает человек, можно объяснить возникающие ошибки и принять меры, препятствующие повторению ошибок в дальнейшем. В то же время у GenAI причины ошибок могут быть спрятаны глубоко внутри «чёрного ящика», а отсутствие человека в цепочке ведет к тому, что присутствие ошибок будет выявляться по факту возникновения инцидентов. Это создает высокий риск и открывает возможности для будущих кибератак.