Заявка на услуги DST

Наш специалист свяжется с вами, обсудит оптимальную стратегию сотрудничества,

поможет сформировать бизнес требования и рассчитает стоимость услуг.

LLMOps расширяет возможности MLOps для генеративного ИИ, уделяя особое внимание оперативному управлению и управлению RAG для повышения эффективности, масштабируемости и упрощения развертывания, одновременно решая проблемы ресурсов и сложности.

Прежде чем углубляться в LLMOps, давайте сначала разберёмся, что такое MLOps. MLOps (Machine Learning Operations) предоставляет комплексную платформу для всех аспектов разработки, обучения, оценки и внедрения продуктов машинного обучения, охватывая такие области управления, как инфраструктура, данные, рабочие процессы и конвейеры, модели, эксперименты и интерактивные процессы.

Интеграция больших языковых моделей (LLM) в MLOps может привести к революционным изменениям в управлении моделями генеративного искусственного интеллекта (GenAI). LLMOps расширяет возможности MLOps, уделяя особое внимание управлению задачами GenAI, включая: управление подсказками , управление агентами и операции расширенной генерации с поиском и дополненной генерацией (RAGOps). RAGOps, расширение LLMOps, охватывает управление документами и базами данных для улучшения моделей GenAI путем включения внешней информации.

Преимущества LLMOps

LLMOps могут значительно снизить рабочую нагрузку и повысить эффективность GenAI, со временем становясь ещё более масштабируемыми и реализуемыми. С этой эксплуатационной точки зрения LLMOps могут способствовать достижению устойчивого развития, обеспечивая документирование данных и контролируемые затраты и обработку. Они также весьма эффективны в повышении производительности моделей. Точность, скорость и эффективное использование ресурсов — лишь некоторые из преимуществ внедрения LLMOps для GenAI. Это поможет в тонкой настройке данных, специфичных для предметной области, применении различных методов интерференции для оптимизации памяти и времени загрузки, эффективном использовании аппаратных и программных возможностей для управления обучением и оптимизации обработки. RAGOps может предоставлять LLM-моделям ещё более качественные данные, что даёт возможность расширить область их возможностей для обработки и ответа. Цепочки LLM также являются инновационной функцией LLMOps, которая позволяет GenAI решать сложные и многоэтапные задачи, распределяя подзадачи по соответствующим моделям, например, для генерации языка или ответа. Это может привести к прямым измеримым достижениям, как в одном случае к 25%-ному росту CTR (кликабельности) и 15%-ному росту продаж, или в другом случае к 20%-ному сокращению времени выполнения операций и 95%-ному успеху доставки.

Процессы и использование LLMOps

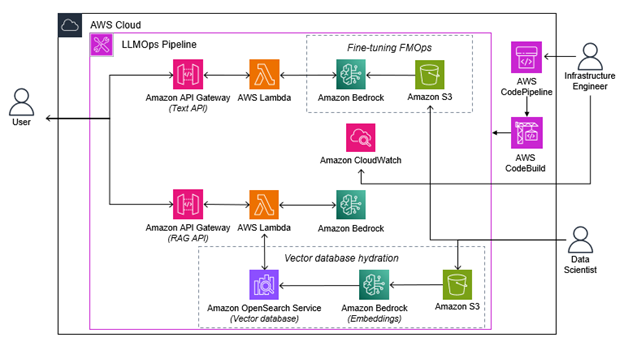

LLMOps можно разбить на типичную серию из 3 шагов, как показано ниже в AWS.

Эти три этапа включают интеграцию, развертывание и настройку. Интеграция подразумевает объединение всех версий кода приложения в одну единую протестированную версию. Развертывание включает перенос инфраструктуры и модели в среду контроля качества и производственную среду для оценки производительности и проведения анализа. Наконец, настройка включает предоставление дополнительных данных для оптимизации модели посредством предварительной обработки, настройки, оценки и регистрации.

Модель можно настраивать различными методами: от тонкой настройки до предобучения и RAG. При тонкой настройке используются ваши собственные данные для настройки модели, при предобучении используется репозиторий немаркированных данных, а RAG использует индексированные данные в векторной базе данных, которая на основе генерации и поиска определяет информацию для отправки в модель.

Azure разделяет этот процесс похожим образом, но по-разному, на 4 этапа: инициализация, экспериментирование, оценка и уточнение, а также развертывание. Они похожи, но отличаются тем, что инициализация чётко определяет цель, структуру и последовательность действий. Поток запросов LLMOps в Azure обеспечивает централизованное размещение кода, управление жизненным циклом, несколько целей развертывания, A/B-развёртывание, условную регистрацию данных и моделей, а также комплексную отчётность.

По мере развития RedHat , LLMOps может значительно упростить этап развертывания модели. Автоматизированное развертывание является важным фактором LLMOps. Сбор и мониторинг данных также значительно упрощаются. Исследовательский анализ данных выполняется на всех этапах: от сбора и очистки до исследования, после чего данные подготавливаются и направляются в систему оперативной разработки. С помощью машинного обучения выявляются закономерности в данных, а LLM оценивается на основе другого набора данных.

Лучшие практики, которым нужно следовать, чтобы минимизировать трудности для LLMOps

При использовании LLMOps возникают некоторые распространённые трудности, но существуют передовые практики , помогающие минимизировать эти трудности. К ним могут относиться высокие требования к ресурсам, большой объём данных, необходимых для обучения, трудности с интерпретацией сложных моделей, а также вопросы конфиденциальности и этики. Создание устойчивой инфраструктуры для LLM имеет решающее значение. Она может быть размещена в публичном облаке, мультиоблачной среде или управляться изнутри, но гибридный облачный подход может быть полезен для снижения финансовых затрат. В связи со сложностью и объёмами данных рекомендуется выбирать специализированные, а не универсальные решения для обеспечения более ограниченной масштабируемости. Ведение надлежащей документации значительно поможет в решении любых возникающих вопросов управления, охватывая все аспекты и предоставляя необходимый контекст в любых ситуациях. Это обеспечит надлежащую документацию обучающих данных, процедур обучения и протоколов мониторинга и их доступность при необходимости. Возможности журналирования в сочетании с мониторингом также рекомендуются для управления и отладки. Это может помочь отследить причины проблем или использовать набор данных для оценки для наблюдения за выходными данными, связанными с определёнными входными данными. По сути, при использовании высококачественных данных, обучении моделей на соответствующих алгоритмах, их развертывании с учетом безопасности и мониторинге в режиме реального времени можно преодолеть многие трудности.

Вердикт: LLMOps могут существенно повлиять на будущее управления моделями ИИ

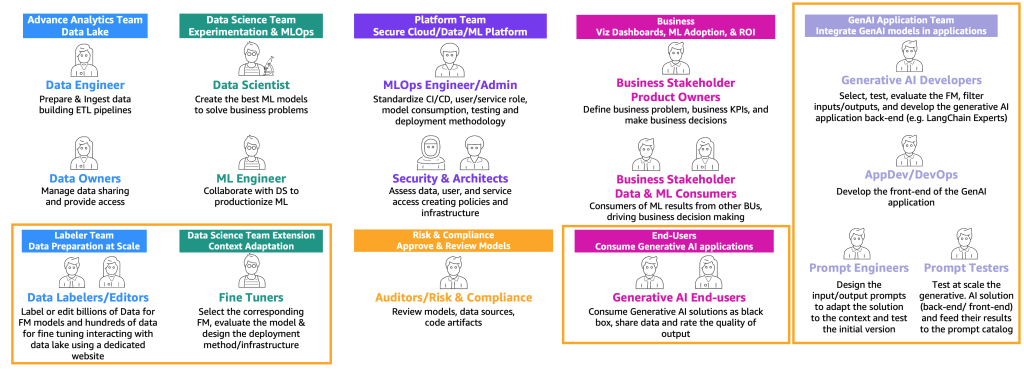

LLMOps — это расширение MLOps, которое может значительно улучшить будущее GenAI, упрощая развертывание моделей, повышая масштабируемость, которая сейчас крайне важна, и улучшая управление ресурсами для повышения эффективности. В зависимости от типа использования существуют специальные профили пользователей LLMOps, которые могут помочь объяснить участие в GenAI. Ниже представлено, как разработчики GenAI будут участвовать в оценке и тестировании, а также в оперативном проектировании и управлении результатами.

Модель зрелости LLMOps учитывает значительную сложность разработки и оперативного развертывания таких моделей. На первом уровне даются простые рекомендации и базовые подсказки. Второй уровень расширяется до систематических методов и комплексного потока подсказок, включая RAG. Затем он переходит на третий уровень, где происходит проектирование подсказок, более адаптированное к потребностям и автоматизированное. На этом этапе также проводятся мониторинг и обслуживание. Заключительный этап включает в себя итерационные изменения, обеспечивающие максимальную производительность модели, а также серьезную тонкую настройку и оценку. Эта модель способствует масштабированию LLMOps, что в конечном итоге позволит экспоненциально масштабировать приложения GenAI.

Наш специалист свяжется с вами, обсудит оптимальную стратегию сотрудничества,

поможет сформировать бизнес требования и рассчитает стоимость услуг.

Ижевск, ул. Воткинское шоссе 170 Е.

Региональный оператор Сколково. Технопарк Нобель

Задать вопрос по почте

Интересно отметить, что такой комплексный подход позволяет не только повысить эффективность моделей, но и значительно снизить риски, связанные с их эксплуатацией. Особенно актуальным представляется вопрос интеграции LLMops с существующими DevOps-практиками — это может создать действительно мощную синергию в процессе разработки и поддержки ИИ-решений.

При этом нельзя не обратить внимание на потенциальные вызовы, связанные с обеспечением безопасности и этичности использования таких моделей. Будущее LLMops видится в направлении создания универсальных фреймворков, которые смогут адаптироваться под различные типы ИИ-систем и бизнес-задачи. Это действительно перспективное направление, за которым будущее индустрии.

Порадовало внимание к «болевым точкам» реальных проектов:

— как поддерживать актуальность моделей в условиях быстро меняющегося контекста;

— как балансировать между качеством генерации и вычислительной стоимостью;

— как обеспечивать прозрачность и отслеживаемость решений LLM в регулируемых отраслях.

Из практических аспектов особенно полезны упоминания о инструментах для:

— версионирования моделей и датасетов;

— A/B‑тестирования вариантов подсказок (prompts);

— логгирования и аудита генераций.

Статья даёт чёткое понимание: LLMops — это не просто «ещё один DevOps», а специфическая практика, учитывающая уникальные свойства LLM (недетерминированность, зависимость от промпта, склонность к галлюцинациям). Рекомендую к прочтению командам, которые уже используют LLM в продакшене или планируют масштабировать эксперименты.

Ключевые сильные стороны статьи:

— Акцент на жизненном цикле модели. Авторы не забывают про этапы, которым часто уделяют мало внимания: сбор обратной связи от пользователей, ретранирование на новых данных, декоммиссию устаревших версий.

— Баланс техники и процессов. Наряду с инструментами (MLflow, Weights & Biases, Prometheus для мониторинга) обсуждаются организационные аспекты: ролевая модель доступа, процедуры одобрения изменений, отчётность для стейкхолдеров.

— Реальные компромиссы. Честно говорится о том, что полная автоматизация LLMops пока недостижима: например, оценка качества генераций часто требует человеческого участия, а оптимизация токенов — итеративного тюнинга.

Из того, что хотелось бы увидеть дополнительно:

— примеры расчёта TCO (общей стоимости владения) для разных сценариев LLMops;

— кейсы интеграции с CI/CD‑пайплайнами;

— рекомендации по выбору облачных vs on‑premise решений.

Тем не менее, статья выполняет главную задачу — формирует системное видение LLMops как дисциплины, объединяющей MLOps, Data Engineering и продуктовый менеджмент. Полезно для тех, кто хочет вывести LLM из режима «песочницы» в масштабное производство.